Diseño Web / Formularios

Desde que Twitter/X restringió el acceso gratuito a su API en 2023, acceder a datos de la red social para investigación o monitoreo de eventos se volvió un desafío. Para quienes trabajamos con métodos digitales, esto implica buscar nuevas estrategias para no perder una fuente clave de información.

En este post presentamos TweetScraperR, un paquete de R desarrollado por Agustín Nieto que permite recolectar tuits sin pasar por la API oficial. Te mostramos cómo funciona, qué posibilidades ofrece y cómo integrarlo fácilmente a tus proyectos.

TweetScraperR es un paquete de R que permite recolectar tuits sin necesidad de credenciales de API. Utiliza una técnica de scraping que simula búsquedas en la interfaz web de Twitter, lo que permite extraer publicaciones según palabras clave, hashtags o cuentas específicas.

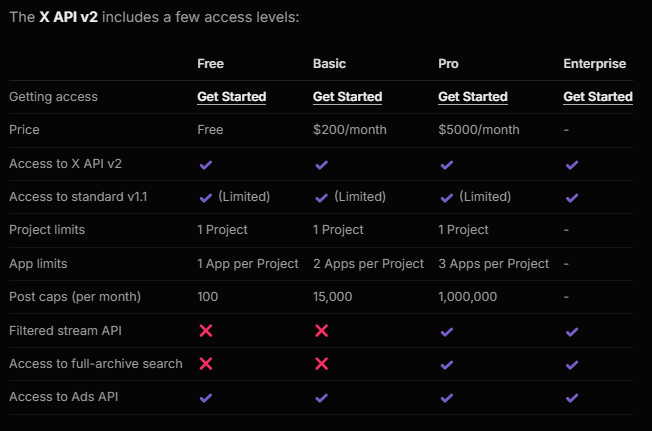

Esta herramienta surge como respuesta directa a un problema concreto: el costo actual de la API oficial de X. Al día de hoy (10/05/2025), acceder a nivel básico de la API que tiene un límite 15.000 tuits por mes cuesta 200 dólares mensuales. Este nivel no tiene acceso al archivo histórico ni al filtered stream (es decir, sin poder recibir tuits en tiempo real filtrados por reglas específicas). Acceder al nivel “Pro” de la API con todas las funcionalidades incluidas y un límite de 1 millón de tweets mensuales el precio se asciende a los 5.000 dólares mensuales.

Para instalar la versión de desarrollo de TweetScraperR desde Github debemos primero debemos tener instalado el paquete devtools. Lo instalamos ejecutando la siguiente línea de codigo

install.packages("a")devtools nos permite gestionar paquetes en R desde no oficiales (como Github, GitLab, etc) y que están en desarrollo activo, por lo que es una herramienta útil para cualquier persona que trabaje con R. Luego a través de devtools instalamos TweetScraperR y acto seguido cargamos el paquete para poder utilizarlo

devtools::install_github(Antes de empezar a extraer tuits, hay que iniciar sesión en Twitter/X. Para elloo, ejecutamos la siguiente función

openTwitter()

Esto abrirá una pestaña nueva en nuestro navegador para inciar sesión. Se puede utilizar la cuenta personal o crear una cuenta específicamente para este fin. Debemos ingresar las credenciales de nuestra cuenta para iniciar sesión

Ahora veamos dos ejemplo prácticos de uso para la extracción, ya que es posible emplear muchas estrategias para este trabajo.

Una vez logueados podemos empezar a extraer nuestros deseados tweets y explorar las funciones que nos ofrece TweetScrapperR para ello.

Por lo pronto presentaremos tres casos básicos para explicar el funcionamiento.

Vamos a suponer dos casos distintos. En uno estamos interesados en la actividad que tiene un medio en la red social (podría ser un influencer, un medio o un político también) cualquier tipo de cuenta. Una vez la tenemos identificada

Supongamos que estamos queriendo relevar la opinión de usuarios sobre la represión de jubilados en congreso. Podemos ejecutar la siguiente línea

tweets_jubilados Eso significa que nos va a traer los tweets en tiempo real que mencionan el termino de busqueda

Tenemos distintas estrategias para tomar pero básicamente es ele

Limites: Twiter/X puede restringir el numero de tweets gratuitos. No por usar el paquete, sino también como usuario a la hora de visualizar los resultados.

Documentacion: Ante la duda de como utilizar una función se puede utilizar la función de R help(nombredelafuncion) para ver los parámetros y los detalles de como utilizar la función.

Teniendo en cuenta el contexto económico actual, herramientas como TweetScraperR ofrecen una alternativa útil para continuar con nuestras investigaciones sin incurrir en costos irrisorios. Además, al ser software libre, fomenta la colaboración, transparencia y la construcción de conocimiento colectivo.

En próximos posts vamos a profundizar el uso de funciones para la exploración de datos y su visualización. Si te interesa podés instalar el paquete y comenzar a probar por tu cuenta.

Conce los trabajos realizados por el Hlab

Diseño Web / Formularios

Web Scraping / Visualización

Diseño Web